Imagine une salle de crise. Nous sommes quelques mois après le 11 septembre.

Les murs sont tapissés de cartes et de rapports confidentiels. Le président scrute les visages alignés devant lui. Des analystes de la CIA, des conseillers, des généraux, regroupés pour éviter les mauvaises décisions et avancer.

Une seule question : que fait Saddam Hussein dans l’ombre ?

Chaque réponse semble renforcer l’idée d’une menace imminente. Des armes de destruction massive ? Peut-être… Probablement. Assurément ! Une décision s’impose : intervenir.

Mais sur quoi repose-t-elle vraiment ?

La CIA, malgré ses moyens colossaux, a fait des erreurs dans son analyse. En confrontant les conséquences de ses décisions, elle s’est rendu compte qu’elle avait mal interprété des données cruciales et biaisé ses conclusions.

Mais comment a-t-elle pu prendre autant de mauvaises décisions malgré leur expertise ?

L’origine de ces erreurs n’était pas technique, ni liée à un manque d’informations. Non, elle était bien plus universelle. Elle reposait sur des mécanismes que nous vivons tous au quotidien : des biais cognitifs.

Ces pièges mentaux, invisibles mais puissants, influencent nos jugements avant même que nous en ayons conscience. Alors, si même la CIA n’a pas su les éviter, comment pouvons-nous espérer y échapper ?

Les mauvaises décisions de la CIA : quand les biais cognitifs mènent à la guerre

Après le 11 septembre, une urgence absolue s’impose. Empêcher une nouvelle attaque. Chaque analyse, chaque discussion tourne autour de la peur d’être pris au dépourvu. Les agents de la CIA cherchent des preuves, des signaux d’alerte.

Chaque indice devient critique.

Mais cette peur biaise tout. Elle force des conclusions rapides, souvent erronées.

Quand l’ancien directeur Adjoint de la CIA reconnaît leurs erreurs

Michael Morell, ancien directeur adjoint de la CIA, a reconnu publiquement les erreurs commises dans l’analyse des armes de destruction massive en Irak. Il a admis que l’agence s’était trompée en évaluant la présence d’armes chimiques, biologiques et nucléaires, en pointant du doigt des failles à la fois dans la collecte des renseignements et dans leur interprétation.

Morell a souligné l’importance cruciale de bien différencier les niveaux de confiance dans les évaluations. Selon lui, il est essentiel de faire la distinction entre une affirmation certaine et une évaluation marquée par un faible niveau de confiance.

Comment la CIA a faussé sa vision de Saddam.

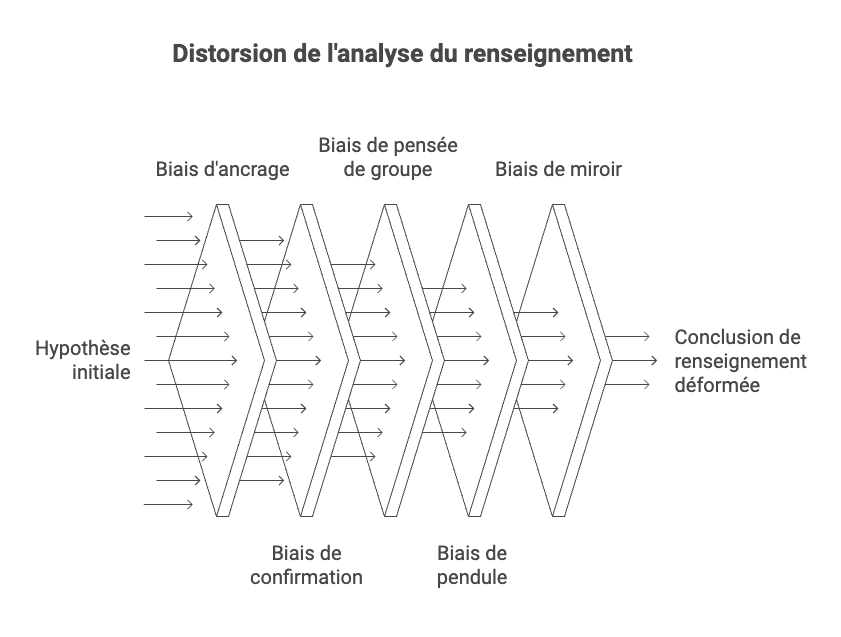

Le passé de Saddam Hussein joue contre lui. Des armes chimiques, il en avait. Alors il doit encore en avoir. Les analystes partent de cette hypothèse et filtrent tout à travers elle. Un camion isolé ? Une usine secrète. Des silences radio ? Une preuve qu’il dissimule quelque chose.

Rien ne remet en question cette base de départ. C’est comme une boussole cassée qui guide tout le raisonnement. C’est ce que l’on appelle un biais d’ancrage, qui pousse à s’appuyer excessivement sur une information initiale, même si elle n’est plus pertinente.

Quand on ne voit que ce qui confirme nos croyances

Chaque élément, même flou, renforce l’idée que Saddam prépare quelque chose. Les analystes veulent des preuves pour convaincre. Mais ces preuves, ils les créent dans leur esprit. Chaque nouveau rapport alimente cette construction.

La boucle est bouclée avant même que les faits ne parlent vraiment.

C’est le biais de confirmation, qui pousse à rechercher et privilégier les informations qui confirment nos croyances, tout en ignorant celles qui les contredisent.

Quand tout le monde se tait pour éviter les conflits

Dans les salles de réunion, personne ne veut briser l’unité. Tout le monde acquiesce. La moindre dissension semble une trahison. Pourtant, c’est souvent cette voix unique qui manque pour éviter le pire. Ici, l’accord règne. Mais cet accord étouffe le doute. Alors les erreurs collectives s’amplifient.

C’est connu sous le nom de biais de pensée de groupe, qui pousse les individus à privilégier l’harmonie et le consensus au sein d’un groupe, même au détriment de leur esprit critique. C’est comme lorsqu’en réunion, tout le monde acquiesce pour éviter de se sentir isolé, même si certains doutent de la décision.

Quand on exagère pour ne plus refaire la même erreur

Une erreur passée pèse. Sous-estimer un danger n’est plus une option. Les agents veulent anticiper, être prudents. Trop prudents. Chaque signal est amplifié.

Chaque détail devient suspect. À force de sur corriger, ils créent une nouvelle erreur. L’excès de zèle fausse tout.

Moins connu, il s’agit d’un biais du pendule, qui pousse à sur corriger une erreur passée en tombant dans l’excès inverse. C’est comme lorsqu’on exagère une précaution pour éviter de reproduire une faute précédente, et que cela conduit à un autre type d’erreur.

Quand on projette nos propres motivations sur les autres

Les analystes imaginent Saddam comme eux. Stratège, calculateur, dissimulant ses intentions. Mais ce n’était qu’une projection. Leurs préjugés construisent un ennemi à leur image.

Cette erreur déforme toute la compréhension de la situation.\

Et, oui un de plus, le biais du miroir, qui nous pousse à projeter nos propres motivations ou logiques sur autrui, comme lorsque l’on suppose que quelqu’un agit pour les mêmes raisons que nous, sans considérer ses différences.

La leçon universelle que nous devons retenir

Ces biais ne touchent pas que les experts. Ils affectent tout le monde. Vous, moi, chaque jour. On croit qu’avoir conscience de ces pièges suffit à les éviter.

Mais c’est là tout le paradoxe : ces biais agissent avant même que notre réflexion consciente ne commence.

Ils fonctionnent comme un filtre invisible qui colore nos pensées, influençant les faits que nous percevons et les jugements que nous formulons. Ce filtre s’impose à nous sans que nous le remarquions. Alors, même en analysant avec soin et en voulant éviter les biais, nous travaillons sur des données déjà altérées.

C’est là que réside le véritable piège d’une mauvaise décision que nous pensons pourtant avoir évité.

Le lien avec vos décisions : quand la CIA vous ressemble

Les biais cognitifs ne sont pas conscients. Vous pensez que vos décisions sont rationnelles ? Pourtant, avant même que vous n’ayez le temps de réfléchir, ces biais agissent en coulisses. Ils influencent vos perceptions, vos jugements et vos actions. C’est leur invisibilité qui les rend si puissants. Et nous sommes tous touchés.

Voici quelques exemples concrets conduisant à de mauvaies décisions dans le quotidien des managers et des RH :

- Ancrage : Lors d’un entretien d’embauche, une première impression peut tout conditionner. Un CV avec une faute d’orthographe, un regard fuyant ? Ces détails deviennent des filtres, influençant l’ensemble de l’évaluation, même si le candidat est parfaitement qualifié.

- Confirmation : Vous avez adopté une nouvelle stratégie. Les résultats sont mitigés, mais vous cherchez instinctivement les données qui confirment votre choix. Les signaux négatifs, eux, sont minimisés ou interprétés comme des anomalies.

- Pensée de groupe : En réunion, une idée est proposée. Tout le monde acquiesce rapidement, même ceux qui doutent. Pourquoi ? Par peur de briser l’harmonie ou de passer pour celui qui freine le projet. Résultat : des erreurs collectives évitables.

- Miroir : Vous imaginez que votre collaborateur à les mêmes motivations que vous. Qu’il agit avec les mêmes priorités que vous. Mais son contexte, ses objectifs et ses valeurs sont peut-être totalement différents.

- Pendule : Après une erreur passée, vous devenez hyper-prudent. Un mauvais recrutement vous pousse à rejeter systématiquement les candidats trop audacieux, par peur de répéter l’échec. Cette surcorrection limite vos choix et crée un autre déséquilibre.

Ces exemples montrent que ces biais ne sont pas de simples failles que l’on peut contourner par la réflexion. Ils agissent en amont, avant même que l’analyse consciente ne commence. Et c’est ce qui les rend si dangereux : nous analysons des faits déjà teintés par eux.

Mais alors, comment s’en sortir ?

Peut-on vraiment dépasser ces pièges invisibles ? Dans la prochaine partie, nous explorerons comment identifier et surmonter ces biais, et surtout, quelles stratégies mettre en place pour prendre des décisions plus éclairées.

Comment surmonter nos biais

Les biais cognitifs sont invisibles mais pas invincibles. Voici comment les identifier et les surmonter avec des solutions concrètes et des exercices pratiques.

Prendre conscience

Comprendre les biais cognitifs commence par reconnaître qu’ils existent et qu’ils nous influencent tous. Cela signifie aller au-delà d’une simple liste des biais comme l’ancrage, la confirmation ou la pensée de groupe. Il faut comprendre leur fonctionnement et pourquoi ils font partie de notre raisonnement. Ces biais agissent comme des filtres invisibles qui teintent notre perception avant même que nous commencions à réfléchir.

Ils nous permettent aussi de gagner du temps de réflexion, une sorte de raccourci mentale que notre cerveau utilise.

Accepter sa vulnérabilité est une étape essentielle. Nous avons tendance à croire que notre expertise ou notre expérience nous protège, mais c’est une illusion. Même les esprits les plus affûtés tombent dans ces pièges. Admettre cette réalité, c’est ouvrir la porte à une réflexion plus lucide et mieux armée pour les surmonter.

Mettre en place des garde-fous

- Rechercher des avis extérieurs : Sollicitez des perspectives variées pour éviter la pensée unique. Invitez un élément perturbateur dans vos réunions qui joue le rôle d’être à contre-courant.

- Réévaluer constamment : Lorsque de nouvelles données apparaissent, revisitez vos jugements initiaux. Posez-vous systématiquement la question : « Cette nouvelle information contredit-elle ce que je pensais ? »

- Challenger ses certitudes : Prenez l’habitude de confronter vos opinions avec des faits opposés. Créez un débat interne pour examiner les contre-arguments que vous auriez ignorés.

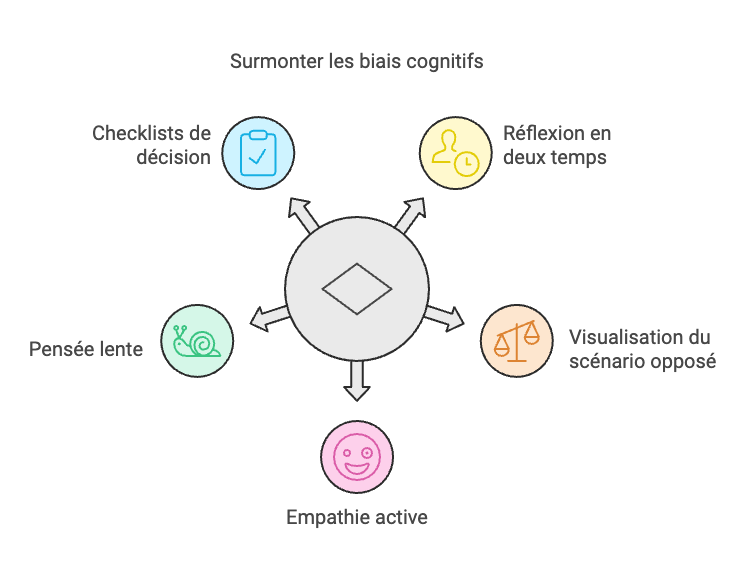

Intégrer des exercices pratiques

- Réflexion en deux temps : Face à une décision importante, notez votre première réaction puis prenez 15 minutes pour y revenir et l’analyser avec recul.

- Visualisation du scénario opposé : Imaginez pourquoi un projet pourrait échouer alors que vous le jugez gagnant, et inversement. Cela force une vue équilibrée.

- Empathie active : Lorsqu’une personne vous agace ou semble irrationnelle, cherchez trois raisons bienveillantes qui pourraient expliquer son comportement.

- Pensée lente : Avant toute décision majeure, ralentissez intentionnellement votre processus pour limiter les réflexes impulsifs.

- Checklists de décision : Développez des listes de vérification comme : « Ai-je envisagé d’autres perspectives ? » ou « Quels faits contredisent mon point de vue ? »

Pourquoi un coach peut aider

Un regard extérieur peut souvent aider à combattre les biais invisibles. Un coach systémique détecte les angles morts de votre raisonnement, ces zones floues que vous ne remarquez pas car elles semblent évidentes. Il pose des questions qui éclairent les choix influencés par vos biais.

Avec un accompagnement adapté, vous apprenez à renforcer vos processus décisionnels. Cela vous permet de prendre des décisions plus solides et plus objectives. En appliquant ces stratégies, vous réduirez progressivement l’influence des biais sur vos choix quotidiens.

Conclusion : une invitation à la réflexion

Les erreurs de la CIA nous rappellent une vérité fondamentale : les biais cognitifs ne sont pas des failles isolées, mais des forces invisibles qui façonnent nos décisions, souvent à notre insu. Ils transforment nos peurs, nos certitudes et nos intuitions en vérités partielles, mais terriblement influentes.

Dans un monde où chaque choix compte, la vraie maîtrise ne réside pas seulement dans l’accumulation d’informations ou d’expertise, mais dans notre capacité à questionner nos propres certitudes et à ralentir face à l’urgence. Car prendre conscience de nos biais, ce n’est pas les éradiquer, mais apprendre à vivre avec eux, les reconnaître et, parfois, les dépasser.

Alors, pose-toi cette question : et si la prochaine mauvaise décision ne venait pas d’un manque de données, mais d’un excès de confiance dans tes jugements ? Le véritable enjeu n’est pas de voir plus clair, mais de voir autrement.